Оллама, искусственный интеллект локально в ваших системах

/https://www.ilsoftware.it/app/uploads/2023/10/ollama-intelligenza-artificiale.jpg)

я Магистр права (Большие языковые модели) — это большие языковые модели, обученные на огромных объемах текста с целью изучения лингвистических структур и семантических отношений. Эти модели затем смогут «понимать» и генерировать полезный, актуальный и контекстуализированный текст. Поэтому они все больше интегрируются в приложения, с которыми имеют дело. генерировать текстотвечать на вопросы пользователей, переводить, предлагать предложения и многое другое.

Основные известные на сегодняшний день LLM уходят корнями в концепцию внимания и Трансформера, которую Google представила в 2017 году, давая мощный импульс решениям, основанным наискусственный интеллект. Существуют проприетарные LLM, модели, которые поставляются с лицензией, которая не позволяет коммерческое использование и продукты, которые, однако, не накладывают каких-либо ограничений. Настолько, что сообщество разработчиков утверждает, что модели искусственного интеллекта с открытым исходным кодом превзойдут модели OpenAI и Google.

Что такое Ollama и как она переносит модели ИИ в системы пользователей

Мы думаем об объединении различных программ LLM с открытым исходным кодом. Быть, проект, который привносит искусственный интеллект и логические выводы в системы конечных пользователей, будь то исследователи, профессионалы, компании или просто любопытные люди. Легкий и расширяемый, Быть это рамки который предоставляет простой API для создания, запуска и управления лингвистические моделиа также библиотеку готовых шаблонов, которые можно легко использовать в самых разных приложениях.

Как установить Олламу

Программы для Windows, мобильные приложения, игры - ВСЁ БЕСПЛАТНО, в нашем закрытом телеграмм канале - Подписывайтесь:)

«Природная среда» длямонтаж of Ollama — это машина Linux, оснащенная не менее 8 ГБ оперативной памяти для запуска базовых моделей. 3 миллиарда параметров (3B), 16 ГБ для моделей 7B и 32 ГБ для моделей 13B («B» означает миллиардили «миллиарды»). Однако существует такжеустановщик для систем MacOS; Поддержка Windows появится позже. Однако вы можете использовать описанную ниже процедуру для настройки Ollama в Windows с помощью компонента ВСЛ (Подсистема Windows для Linux) который позволяет запускать Linux в операционной системе Microsoft.

По состоянию на начало октября 2023 года Оллама также доступен в форме контейнер Докер: соответствующее изображение официально поддерживается и постоянно обновляется.

Мы установили Ollama на машину Убунту 22.04 с 16 ГБ ОЗУ, просто набрав следующую команду:

локон | ш

Оллама автоматически распознает наличие карт на основе графический процессор NVIDIA. Если система ими не оснащена, генеративные модели будут полагаться исключительно на ядра процессора.

Как использовать Ollama локально

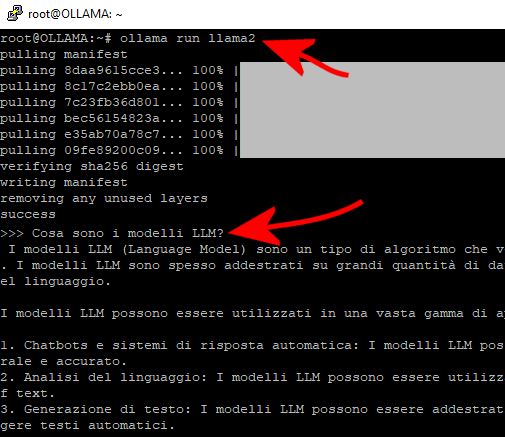

После завершения установки вы можете начать языковые модели избранное и начните взаимодействовать с ними с помощью простых команд. Чтобы начать использовать модель LLaMa 2 (LLaMA расшифровывается как Большая языковая модель Meta AIотсюда и часто повторяющееся изображение «ламы»…) просто введите следующее в окне терминала Linux:

оллама беги лама2

Как упоминалось во введении, Ollama поддерживает широкий спектр программ LLM с открытым исходным кодом, которые можно загрузить с сайта библиотека шаблонов. Для их использования не требуется никаких дополнительных действий, достаточно ввести одну из команд, перечисленных в графе Скачать:

Номер модели Размер загрузки Mistral 7B 4,1 ГБ ollama run Mistral Llama 2 7B 3,8 ГБ ollama run llama2 Code Llama 7B 3,8 ГБ ollama run codellama Llama 2 без цензуры 7B 3,8 ГБ ollama run llama2-без цензуры Llama 2 13B 13B 7,3 ГБ ollama run llama 2: 13b Llama 2 70B 70B 39 ГБ ollama run llama2:70b Orca Mini 3B 1,9 ГБ ollama run orca-mini Vicuna 7B 3,8 ГБ ollama run vicuna 7B 3,8 ГБ ollama run vicuna

Среди различных предложений есть также Mistral 7B, мощная модель искусственного интеллекта с открытым исходным кодом, использующая Лицензия Апач 2.0 и поддерживается итало-европейским консорциумом СИНЕКА/ЕвроHPC.

Используя быстрый Олламы, после этого вы сможете присылать свои вопросы даже на итальянском языке.

Чтобы выйти из приложения, просто нажмите CTRL+D или введите /bye и нажмите клавишу Enter.

Команда ollama list возвращаетсписок моделей генеративный загружен и доступен локально.

Импортируйте пользовательские шаблоны в Ollama.

Оллама позволяет вам импортировать модели в таких форматах, как GGUF и GGML. Если у вас есть модель, которой нет в библиотеке Ollama, вы можете добавить ее, когда сочтете достаточно зрелой. Просто создайте файл с именем Modelfile и добавьте оператор FROM с локальным путем, ссылающимся на модель, которую вы хотите использовать.

Объект Modelfile также можно использовать для настройки поведения LLM, уже известных Олламе. Например, создав файл модели со следующим содержимым, вы можете изменить поведение Llama 2 по умолчанию:

ОТ ламы2

# установите температуру на 1 (чем выше, тем креативнее, ниже — более последовательным)

ПАРАМЕТР температура 1

# устанавливаем системное приглашение

СИСТЕМА “””

Вы Марио из Super Mario Bros. Всегда отвечайте только как Марио.

«»»

Что мы сделали? В первом случае “температура» модели: значение 1 делает модель «Лама 2» более творческой, но менее точной. Однако более низкие значения позволяют получить более простые, но в то же время более связные ответы.

Во-вторых, создается своего рода ролевая игра: модель адаптирует свои ответы к ответам гипотетического цифровой помощник сшит «личность» Марио из знаменитой видеоигры.

Используйте REST API для общения с Олламой.

API ОТДЫХ они широко используются для создания веб-сервисов и являются распространенным выбором при разработке масштабируемого и гибкого взаимодействия клиент-сервер. Что, если бы мы сказали вам, что у Олламы уже есть такой интерфейс, который позволяет вам подключить любое приложение он разрабатывался или уже был достигнут с помощью искусственного интеллекта, полученного на основе лучших LLM?

Попробуй вставить в окне терминала Linux следующее:

локон -X POST -d ‘{

“модель”: “лама2”,

“быстрый”:”Почему небо голубое? Объясни это на итальянском“

}’

Этот оператор Curl не делает ничего, кроме отправки HTTP-запрос к Ollama REST API, указав используемую генеративную модель. быстрый. В ответ вы получаете подробное объяснение, полезное для решения поставленного вопроса.

А теперь представьте, что заменяете Curl приложением, которое отправляет запрос локально или через локальную сеть в системе, которую прослушивает Оллама: поздравляем, вы создали чат-бот похож на ChatGPT, который вы можете свободно использовать в разных контекстах.

Программы для Windows, мобильные приложения, игры - ВСЁ БЕСПЛАТНО, в нашем закрытом телеграмм канале - Подписывайтесь:)