Запустите Llama 3 локально на Windows и Raspberry Pi 5.

/https://www.ilsoftware.it/app/uploads/2024/04/eseguire-llama-3-in-locale-come-fare.jpg)

В апреле 2024 года Meta пошла еще дальше, предложив то, что она представляет как Большая языковая модель (Магистр права) наиболее продвинутый, доступный в настоящее время на сцене. Это о Лама 3, мощная языковая модель, предварительно обученная и оптимизированная с использованием 8 миллиардов (8B) и 70 миллиардов (70B) параметров, в зависимости от версии. По этой причине он подходит для очень широкого спектра возможных областей применения.

По сравнению со своим предшественником Llama 2, его работа основана на наборе данных, который в семь раз больше и который, прежде всего, также включает в себя неанглийские данные высокое качество на более чем 30 языках. Твердый трубопровод Из фильтрация данных направлен на обеспечение высочайшего качества обучающих данных, объединяющих информацию из разных источников.

В отличие от других фирменных моделей, в Llama 3 используется открытый подход а также может использоваться для разработки коммерческих проектов без проблем с точки зрения лицензирования.

Программы для Windows, мобильные приложения, игры - ВСЁ БЕСПЛАТНО, в нашем закрытом телеграмм канале - Подписывайтесь:)

Хотя, как мы показываем в нашей статье, фаза вывод довольно легко, создание модели Llama 3 потребовало огромной вычислительной мощности, при этом инженеры Meta использовали батарею графических процессоров NVidia H100 (более 24 500).

Как запустить Llama 3 локально с помощью LM Studio

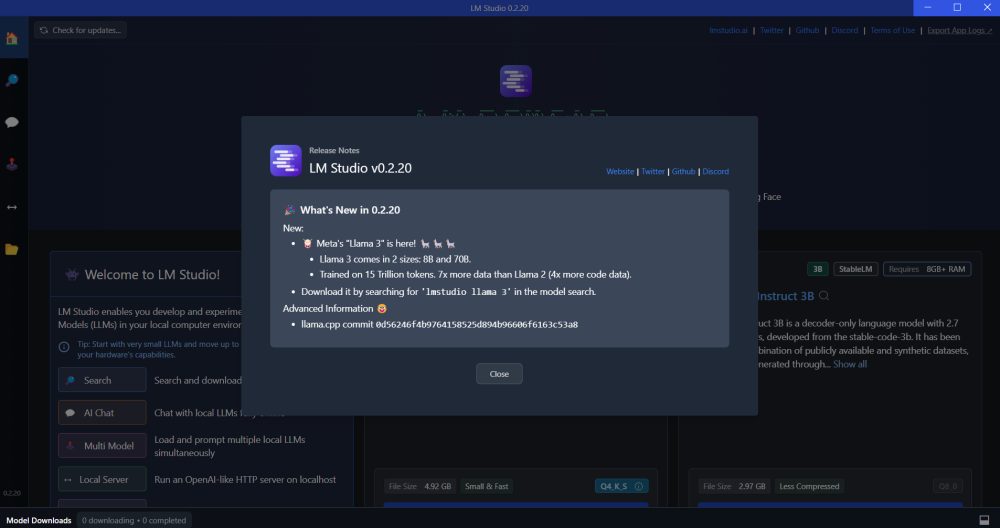

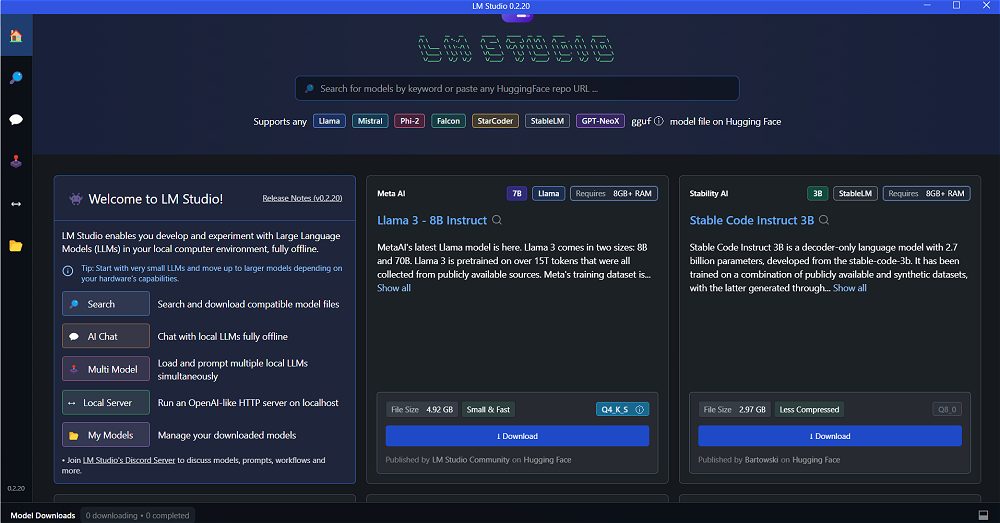

Пер попробуй Ламу 3 локально из системы под управлением Windows, мы предлагаем загрузить и установить программное обеспечение с открытым исходным кодом. ЛМ Студия. Мы говорили об этом вместе с Быть в статье основное внимание уделялось тому, как запускать LLM в ваших системах с помощью графического интерфейса.

С первого запуска LM Studio заявляет о своей совместимости с широким спектром LLM, включая недавние. Лама 3 8Б и 70Б. Используя поле поиска выше или поля, представленные чуть ниже него, вы можете выбрать генеративная модель (или модели!), которые вы хотите использовать. Например, чтобы уменьшить вес данных для загрузки, попробуем выбрать Лама 3 – 8B Инструктирует разрешая загрузку почти 5 ГБ информации.

Начните общаться с загруженной моделью локально

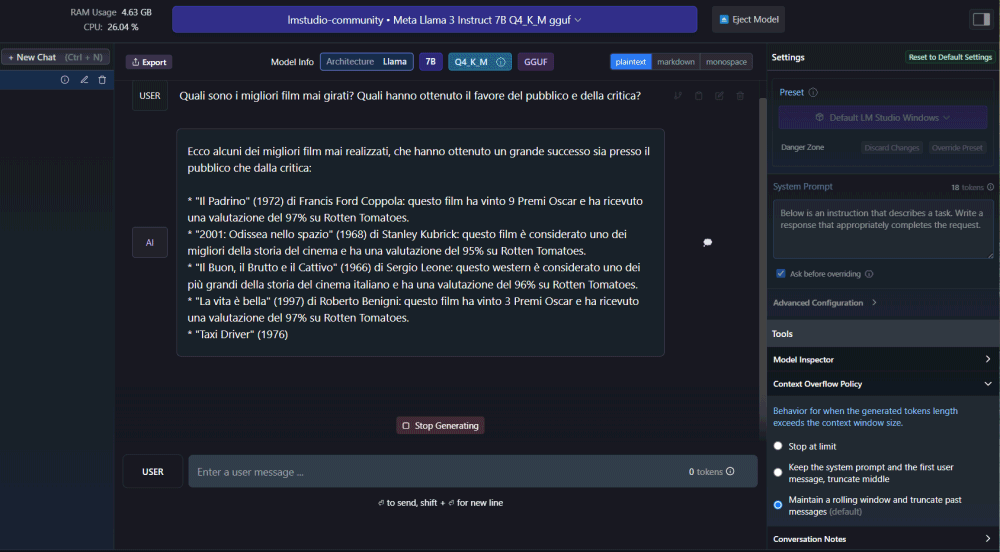

После завершения процедуры загрузки модели кнопка AI-чат расположенный внутри левой колонки, позволяет вам начать разговор очень похоже на то, что происходит с ChatGPT. Разница в том, что в этом случае никакие данные не передаются на удаленные серверы и вся информация всегда остается храниться локально.

Если вы загрузили несколько LLM локально, LM Studio позволяет вам выбирать тот, который вы хотите использовать каждый раз для начала сеанса чата.

На этом этапе, используя поле Введите сообщение пользователя ниже вы можете начать пообщаться с Ламой 3 (как и в других моделях) для проверки качества предлагаемых ответов в зависимости от входных данных (быстрый) передано в систему.

Используйте API для связи с LM Studio.

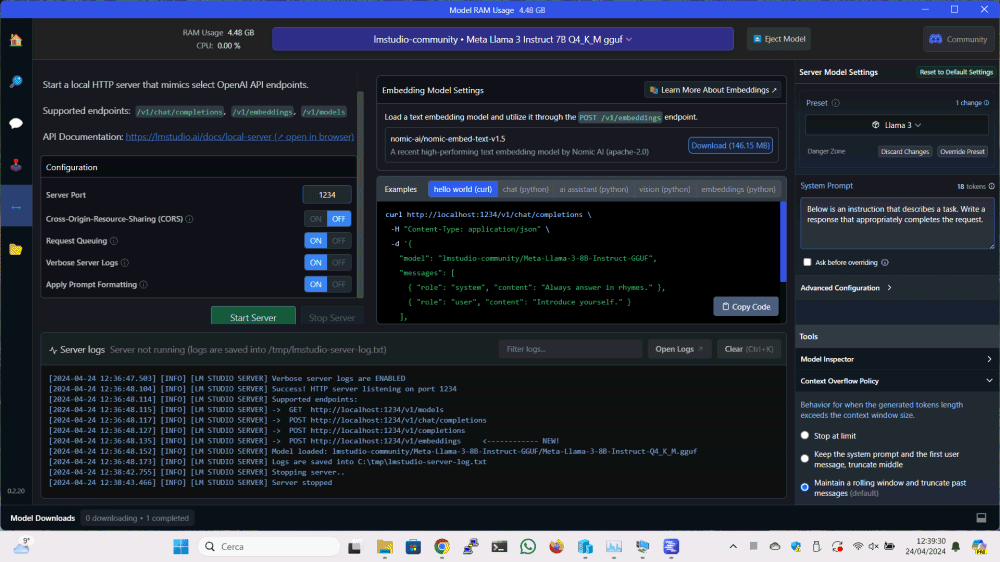

Одной из лучших особенностей LM Studio является Поддержка API (Интерфейс прикладного программирования). Эта функция, очевидно, подмигивает разработчикам, позволяя им взаимодействовать с различными моделями, загруженными локально. из ваших приложений.

Процесс очень прост: просто нажмите Локальный серверкнопку в левом столбце, укажите LLM, который нужно использовать, и позвольте LM Studio запустить серверный компонент посвященный, нажав на кнопку Запустить сервер.

По умолчанию вы можете общаться с сервером LM Studio, используя протокол HTTP на порту 1234. Однако вы можете настроить поведение сервера по своему усмотрению.

В коробке Примерыпрограмма предоставляет несколько примеров программный код готов к использованию, для использования в ваших собственных проектах, для отправки быстрый на выбранную модель и получите ответ выход то есть уместный и точный аргумент.

Не утруждая себя разработкой, вы также можете выполнить простые тесты с помощью утилиты командной строки Curl. Например, с помощью следующей команды вы можете получить список моделей, установленных через LM Studio:

завиток

В примере мы ссылаемся на локальный компьютер localhost, но, очевидно, соответствующим образом изменив конфигурацию брандмауэра Windows, вы также можете отправлять запросы к LM Studio из других систем в локальной сети. Более подробную информацию можно найти в статье поддержки. Сервер LM Studio.

Как запустить Llama 3 на плате Raspberry Pi 5

В статье, цитированной в начале, мы представили Оллама веб-интерфейс то есть версия, оснащенная графическим интерфейсом популярного инструмент на основе CLI (Интерфейс командной строки), который позволяет вам взаимодействовать с любой генеративной моделью с открытым исходным кодом, доступной сегодня.

В прошлом мы много говорили об Олламе и возможности внедрения ИИ в ваши системы. С Быть совместимо с Llama 3 и что приложение также распространяется в версии для Linux, вы можете подумать об использовании его, например, на Плата Raspberry Pi 5.

Просто откройте окно терминала операционной системы, на которой вы установили. Малиновый Пи 5 затем введите следующие команды:

локон -fsSL | ш

оллама беги лама3

Вторая команда при первом выполнении запрашивает локальную загрузку модели Llama 3, а затем подготавливает ее для использования с Ollama. На следующих шагах та же команда просто указывает Ollama на желание использовать модель Llama 3. Представленное далее приглашение ожидает передачи приложения в LLM.

Для получения дополнительной информации вы можете обратиться к нашему углубленному анализу Ollama: те, кто хочет использовать более привлекательный и практичный веб-интерфейс, наконец-то могут установить Ollama WebUI.

Также в этом случаеAPI ОТДЫХ выделенный позволяет вам поговорить с Олламой и с базовым LLM Llama 3 из других приложений, работающих в той же системе или на других устройствах. По умолчаниюПожар в Олламе прослушивает порт 11434: это означает, что вы можете оставить плату Raspberry Pi 5 подключенной к локальной сети и взаимодействовать с база знаний Llama 3 в режиме клиент-сервер с других устройств.

Вступительное изображение: Дизайнер второго пилота.

Программы для Windows, мобильные приложения, игры - ВСЁ БЕСПЛАТНО, в нашем закрытом телеграмм канале - Подписывайтесь:)