Давайте покажем, как немедленно попробовать Google Gemma локально, в ваших системах.

/https://www.ilsoftware.it/app/uploads/2024/02/provare-eseguire-google-gemma-in-locale.jpg)

Гугл Джемма — это новое семейство открытых генеративных моделей, призванное помочь разработчикам и исследователям ответственно создавать приложения на основе искусственного интеллекта. Новые модели, уже общедоступные, то есть Джемма 2Б е 7Б, являются результатом тех же исследовательских усилий и технологических достижений, которые привели к недавней презентации Gemini. Разработан Гугл ДипМайнд в сотрудничестве с другими командами компании Mountain View модели Gemma Открытый исходный код и может использоваться разработчиками бесплатно, даже в коммерческих целях.

Основные возможности моделей Google Gemma

Модели Gemma легкие, современные и обеспечивают высокая производительность несмотря на его небольшой размер. Большой плюс в том, что их можно казнен напрямую на тетрадяхрабочей станции или на платформе Google Cloud, полагаясь на Vertex AI e Движок Google Кубернетес (НПО).

Чтобы заглушить слухи о том, что в мае 2023 года описывались сторонние модели с открытым исходным кодом на пути к обгону Google и OpenAI, компания под руководством Сундара Пичаи решает пойти по этому пути. Шаблоны Google Gemma не только открыты и доступны для бесплатного использования, но и могут быть интегрированный с разнообразными платформы и популярные инструменты, такие как Kaggle, Colab, Обнимающее лицо, MaxText е Нвидиа НеМо. Эта интеграция позволяет разработчикам использовать модели Gemma в привычных средах и с широко распространенными инструментами, выбирая те, которые они предпочитают.

Программы для Windows, мобильные приложения, игры - ВСЁ БЕСПЛАТНО, в нашем закрытом телеграмм канале - Подписывайтесь:)

Google также предоставляет Инструментарий ответственного генеративного искусственного интеллекта поддерживать безопасное использование ИИ, поощрять сотрудничество и ответственное использование. Модели Gemma используют автоматизированные методы для фильтровать личную информацию и другие конфиденциальные данные из наборов данных. Кроме того, компания объявила о выпуске полного комплекта эталон оценить Джемму по сравнению с другими моделями.

Однако обе модели, Gemma 2B и Gemma 7B, текстово-ориентированныйв том смысле, что они получают входные данные от текст на естественном языке (быстрый), обработать его и по очереди вернуть некоторый текст выход.

новизна представленных с Джеммой, так много: слишком много даже для подробной статьи. Поэтому мы приглашаем заинтересованных лиц прочитать этот пост на итальянском языке».новое семейство открытых моделей«. Давайте вместо этого сосредоточимся на как установить Джемму и используйте его локально или в облаке.

Как установить Google Gem локально

Как мы и предполагали во введении, Gemma предназначена для работы на любом оборудовании, в локали или в облаке. Подумайте о серверах, рабочих станциях, ноутбуках, мобильных устройствах и т. д. пользовательское приложение пользователями. Более того, хорошая новость заключается в том, что я генеративные модели Google может быть оптимизирован и подвергнут полной автономии действиям тонкая настройка направлен на расширение ее способностей или «специализацию» поведения Джеммы, чтобы лучше выполнять «специальные» задачи.

Чтобы начать и иметь возможность запускать локально, Джеммадаже имея довольно скромный набор аппаратных ресурсов, можно начать с самой лёгкой модели с двумя миллиардами параметров (2В) и затем со временем перейти на 7В.

Настройка Gemma в системе Ubuntu с помощью Ollama

Gemma можно использовать без ограничений на широком спектре платформ и операционных систем. Попробуем, прежде всего, настроить его работу на одном Linux-машинав нашем случае Ubuntu 22.04.

Пер используйте Джемму локально конечно, можно следовать Инструкции Google опубликованы на Hugging Face. Обязательным требованием является наличие языка. Питон е ди пункт (инструмент управления пакетами для Python; его название представляет собой аббревиатуру от «Pip устанавливает пакеты“).

Однако со своей стороны мы хотели бы рекомендовать использование Быть. Проект с открытым исходным кодом, Ollama привносит искусственный интеллект в свои локальные системы: легкую и расширяемую структуру, обеспечивающуюAPI (Интерфейс прикладного программирования) для создания, запуска и управления языковыми моделями, позволяя пользователям запускать генеративные модели локально в macOS, Linux и Windows.

Платформа автоматически распознает наличие карт на основе графический процессор NVIDIA (в противном случае он полагается на ядра ЦП для обработки, очевидно, с пониженной производительностью) и предлагает широкий спектр интеграций. Установить Ollama можно с помощью простой команды терминала, и они тоже доступны. Докер-образы должностные лица.

Установка Ollama и добавление генеративных моделей Google Gemma

Пер установить Олламупросто введите следующую команду из окна терминала Linux:

локон | ш

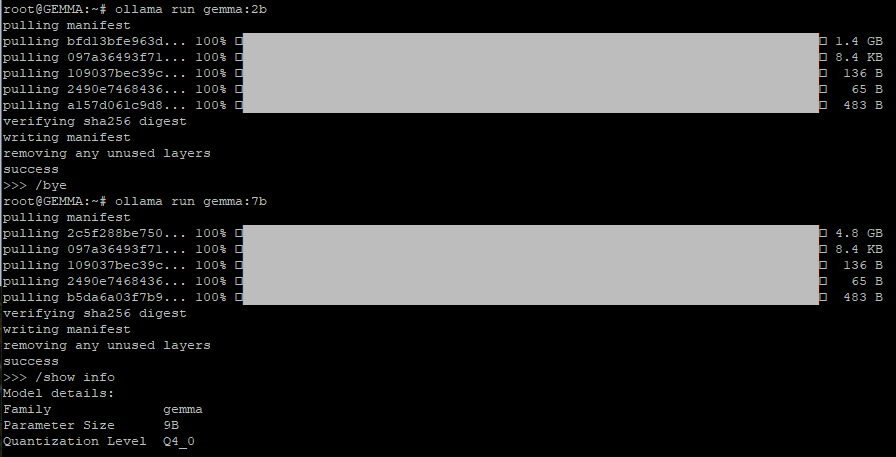

На этом этапе вы можете выбрать, загружать и устанавливать LLM (большая языковая модель) Gem 2B или Gem 7B, используя одну из следующих двух инструкций (обеим можно дать использовать обе Google шаблоны):

Оллама беги, Джемма:2b

Оллама беги, Джемма:7b

Любопытно, что при вводе /show info в командной строке Ollama платформа указывает 3B в качестве количества параметров, поддерживаемых Gemma 2B, и 9B в случае модели Gemma 7B. Но это все.

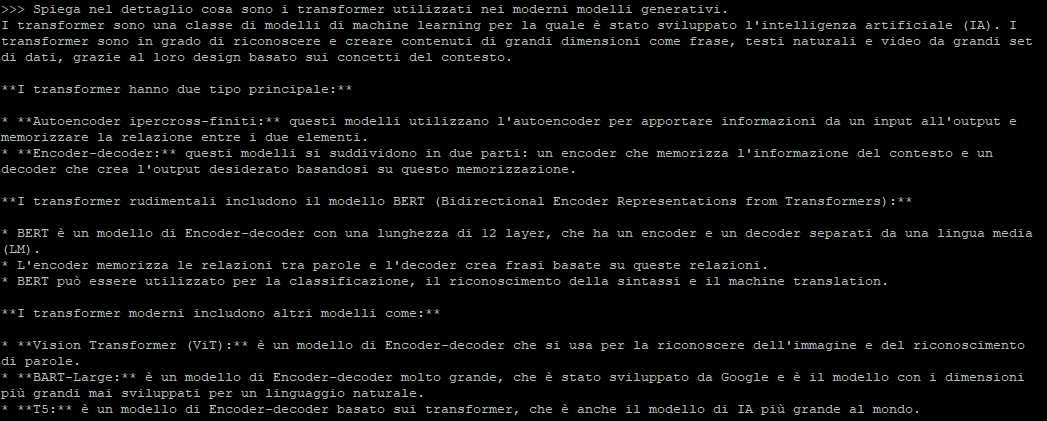

Передайте быстрый к Джемме и получить аргументированный ответ

В командной строке Олламы вы можете ввести свой вопрос. естественный язык для отправки в генеративную модель Google. После нажатия клавиши Enter, в зависимости от модели, выбранной с помощью команды запуска ollama, вы получите желаемый ответ.

С использованием Веб-интерфейс Олламы вы даже можете создать своего собственного чат-бота, взаимодействуя с ним напрямую через графический интерфейс. В другом углубленном исследовании мы увидели, как настроить локального чат-бота с графическим интерфейсом, используя основные программы LLM, включая Google Gemma.

Как только он будет установлен, Оллама отображает сообщение, подобное следующему: «API Ollama теперь доступен по адресу 127.0.0.1:11434.«. Это означает, что невозможно взаимодействовать с различными генеративными моделями только через текстовый интерфейс, но также и с помощью специального API Ollama.

Следующая команда используетAPI ОТДЫХ Олламы для связи с Джеммой и получения ответа в формате JSON, а затем соответствующим образом управляемого:

curl -d ‘{ “model”: “gemma:2b”, “prompt”:”Почему небо голубое?” }’

Также существуют версии Ollama для macOS и Windows, которые можно бесплатно загрузить с сайта страница загружена. Кроме того, возможности практически безграничны благодаря библиотекам, которые позволяют взаимодействовать с Ollama через код Python и JavaScript. Вы можете установить эти библиотеки, используя пункт от Python e НПМ за JavaScript.

Программы для Windows, мобильные приложения, игры - ВСЁ БЕСПЛАТНО, в нашем закрытом телеграмм канале - Подписывайтесь:)